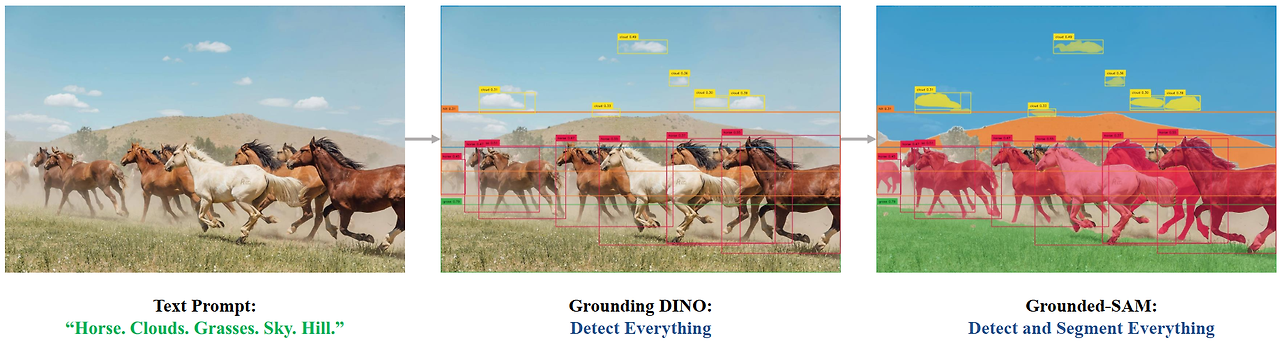

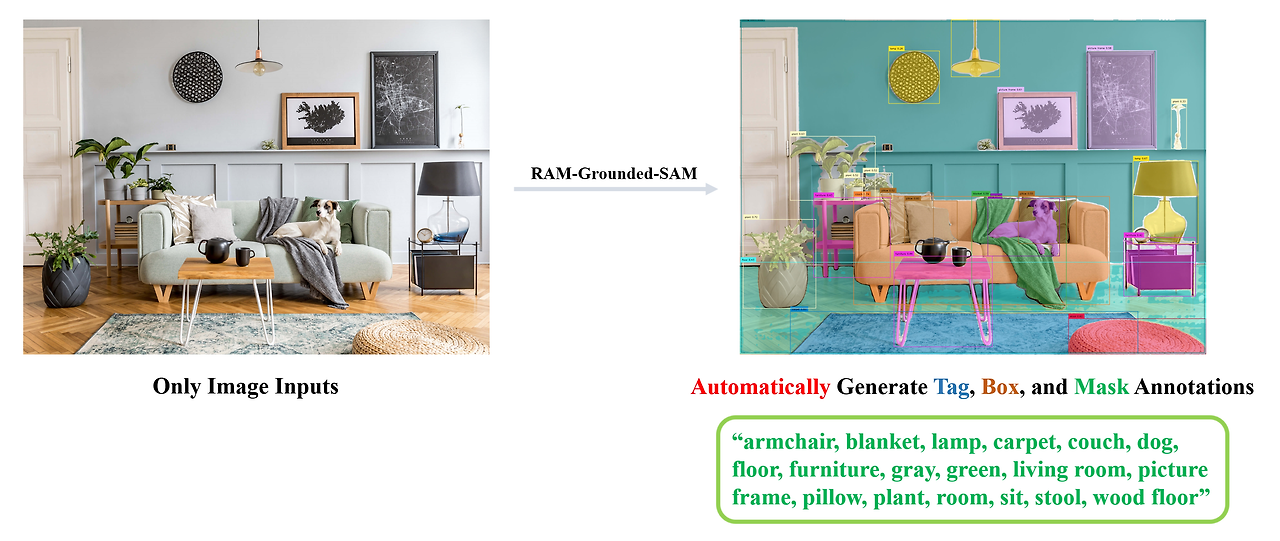

우리는 텍스트 입력으로 무엇이든 감지하고 분할하는 것을 목표로 하는 Grounding DINO 와 Segment Anything을 결합하여 매우 흥미로운 데모를 만들 계획입니다 ! 그리고 우리는 계속해서 이를 개선하고 이러한 기반을 바탕으로 더욱 흥미로운 데모를 만들 것입니다. 그리고 우리는 이미 arXiv 프로젝트에 대한 전반적인 기술 보고서를 발표했습니다. 자세한 내용은 Grounded SAM: Assembling Open-World Models for Diverse Visual Tasks를 확인하세요.

우리는 Segment-Anything을 기반으로 모든 사람이 새로운 프로젝트를 공유하고 홍보할 수 있도록 기꺼이 도와드립니다 . 여기에서 커뮤니티의 더 놀라운 데모와 작업을 확인하세요: 하이라이트 확장 프로젝트 . 새 이슈( project태그 포함)를 제출하거나 새 풀 요청을 제출하여 새 프로젝트의 링크를 추가할 수 있습니다.

https://github.com/IDEA-Research/Grounded-Segment-Anything

GitHub - IDEA-Research/Grounded-Segment-Anything: Grounded-SAM: Marrying Grounding-DINO with Segment Anything & Stable Diffusion

Grounded-SAM: Marrying Grounding-DINO with Segment Anything & Stable Diffusion & Recognize Anything - Automatically Detect , Segment and Generate Anything - GitHub - IDEA-Research/Grounded-...

github.com

🍄 이 프로젝트를 구축하는 이유는 무엇입니까?

이 프로젝트의 핵심 아이디어는 복잡한 문제를 해결하기 위한 매우 강력한 파이프라인을 구축하기 위해 다양한 모델의 장점을 결합하는 것입니다 . 그리고 이것은 모든 부품을 개별적으로 또는 조합하여 사용할 수 있고 유사하지만 다른 모델로 교체할 수 있는 강력한 전문가 모델을 결합하기 위한 워크플로우라는 점을 언급할 가치가 있습니다(Grounding DINO를 GLIP 또는 기타 감지기로 교체/Stable-Dino 교체 등). ControlNet 또는 GLIGEN으로 확산/ ChatGPT와 결합) .

'AI > Segmentation' 카테고리의 다른 글

| SAM, SAM2, SAMURAI 발표자료 (0) | 2024.12.10 |

|---|---|

| Depth-Anything (0) | 2024.01.29 |

| ZoeDepth: 상대적 깊이와 메트릭 깊이 결합 (공식 구현) (1) | 2024.01.24 |

| EdgeSAM (0) | 2023.12.25 |

| SAM (SegmentAnything)-meta (0) | 2023.12.25 |

댓글